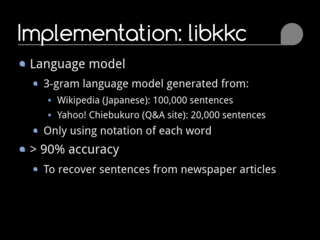

nwc2010-libkkcの作業が収束しなくて、「ヴ」を含む単語の処理が全然できていなかったとか、JUMAN対応を入れてはみたもののあまりの遅さに使い物にならないのでこれを投げ捨ててChaSen対応を入れてみたとかそんなことやってました。あんまり機能追加しちゃうとOpenBSD上で動かす際に(それぞれのエンジンを動かすところから始めないといけないので)色々面倒なことになるのですが…当面はdata.arpaを得るところまではLinux上でやれば良いと割り切ることにします。

…で。

nwc-toolkit、これを動かせるようにするのがまあ面倒で。現時点ではGoogle Codeにあるnwc-toolkit-0.0.2.tar.gzと、GitHubにあるxen/nwc-toolkit(おそらく本家からforkしたと思われる)があり、xen版はv0.1.0ということになっているようです。どちらを使うかについては、xen版のnwc-toolkit-0.0.2ブランチとnwc-toolkit-0.0.2.tar.gzを比較すると違いはなかったのと、nwjc2vec:『国語研日本語ウェブコーパス』 に基づく単語の分散表現データ(言語処理学会第23回年次大会発表論文集(2017年3月)・浅原正幸・岡照晃)(PDF)に0.0.2を使ったとの記述があるので、0.0.2を使うことにしました。とはいえ、論文の脚注にnwc-toolkitが現在公開停止と書いてあるのは一体どういうことなのかというのは気になるところです。

とりあえずソースコードを展開して、Debian-12/amd64で./configure; make…できません。<iconv.h>はあるのにlibiconvが無いと言われてしまいます。そもそもglibcはlibiconvを取り込んでいるのでlibiconvが無くても問題は無いはずです。autotools(autoconf, automake)で使うファイルをいじってコンパイル自体はできるようになるものの、シンボルを解決できないためにオブジェクトを作れない問題が直せなかった(ライブラリのリンク順を変えれば済む問題なのだけどこれがどうにもできなかった)のでCMake化してしまいました。ビルドができるようになったとしても、動作するかどうかは別途試す必要があります。面倒なのであまりやりたくないんですけど。

それにしても…このコードは随分と長い間うち捨てられていたコードですねえ。この程度の修正で動かせるようになるなら誰でもできるので必要になった時にやれば良いという考えなのかもしれませんが、論文の作成に使ったツールくらいはきちんとした形で公開を続けていてほしいものですし、必要最低限のメンテナンスも続けて頂きたいものだと思ってしまいます。とはいえ、nwc-toolkitを使用した最近の事例としてNWJCの文抽出(文選択)(2023-04-04)がありますし、実は自分のソースコードの扱い方が根本的に間違っていたのではないかという気もしています。55.7kg(22:55)